ChatGPT(챗GPT)의 모델 이름이 Transformer인 이유는 무엇입니까? RNN과 Transformer의 주요 차이점 공개: 신경망 모델 탐색!

신경망 모델은 자연어 처리 및 기계 번역과 같은 다양한 분야에서 중요한 역할을 합니다. 대표적인 두 가지 모델인 순환 신경망(RNNs, Recurrent Neural Networks)과 트랜스포머(Transformers)는 이러한 분야에 혁명을 일으켰습니다. 이 글에서는 RNN과 트랜스포머의 흥미로운 세계에 대해 자세히 알아보고 각 모델의 장점과 단점, 획기적인 연구 결과를 살펴봅니다. 이러한 모델 간의 주요 차이점을 이해하면 각각의 애플리케이션에 대한 인사이트를 얻고 특정 작업에 적합한 모델을 선택할 때 정보에 입각한 결정을 내릴 수 있습니다. 이제 흥미진진한 탐험의 여정을 시작하세요!

목차

1. 순환 신경망(RNN, Recurrent Neural Networks)의 이해

2. 트랜스포머 모델 공개(Transformer Model)

3. RNN의 장점과 단점

4. Transformer의 장점과 한계

5. 획기적인 연구 및 애플리케이션

6. ChatGPT의 모델 이름이 Transformer인 이유는 무엇입니까?

TOP 맨위로

1. 순환 신경망(RNN, Recurrent Neural Networks)의 이해

신경망의 한 종류인 순환신경망은 순차적 데이터 처리에 탁월하여 언어 모델링 및 음성 인식과 같은 작업에 적합합니다. 기존의 피드포워드 네트워크와 달리 RNN은 이전 시간 단계의 정보를 보유할 수 있는 숨겨진 상태를 가지고 있습니다. 이러한 반복적인 특성 덕분에 순차적인 데이터 전반에서 종속성을 포착할 수 있어 시간적 역학이 필요한 작업에 효과적입니다. 그러나 RNN은 사라지는 기울기 및 제한된 병렬 처리와 같은 문제로 인해 장거리 종속성에서 성능을 저해할 수 있습니다.

TOP 맨위로

2. 트랜스포머 모델 공개(Transformer Model)

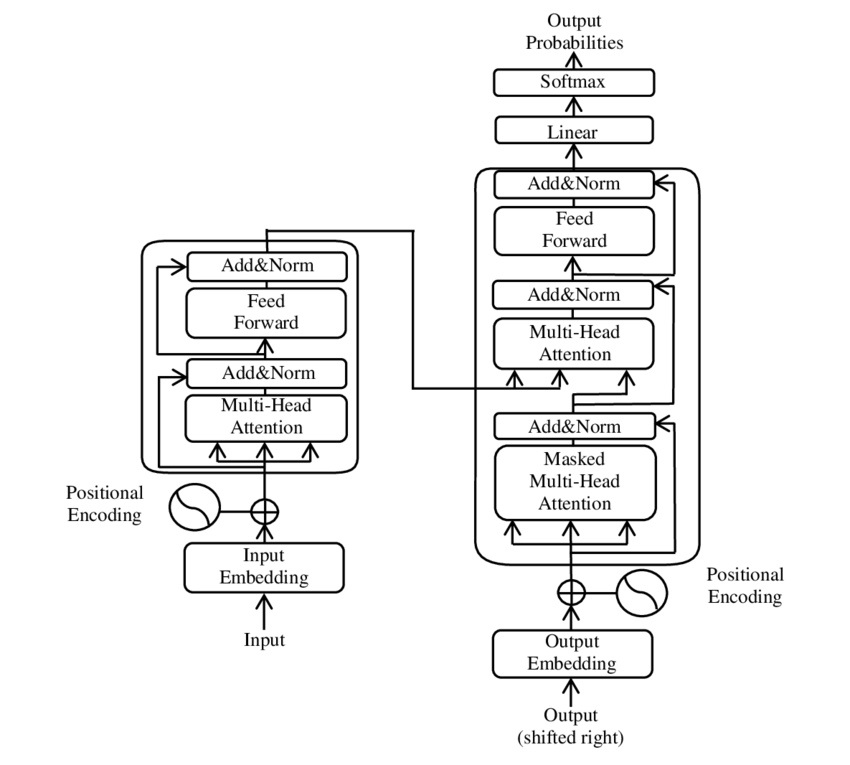

트랜스포머는 2017년 Google Brain의 Vaswani 등이 발표한 "주의력만 있으면 된다(Attention Is All You Need)"라는 제목의 연구 논문에서 소개되었습니다. RNN과 달리 트랜스포머는 자체 주의 메커니즘(Self-attention Mechanism)을 활용하여 데이터 시퀀스를 처리합니다. 트랜스포머는 장거리 종속성을 처리하고 계산을 효과적으로 병렬화할 수 있는 능력으로 주목을 받았습니다. 이 아키텍처는 RNN이 직면하는 순차적 처리 병목 현상을 제거합니다. 입력 시퀀스의 여러 위치를 동시에 처리함으로써 트랜스포머는 문맥 정보를 보다 효율적으로 캡처하여 기계 번역 및 감정 분석과 같은 작업의 성능을 개선할 수 있습니다.

TOP 맨위로

3. RNN의 장점과 단점

RNN은 순차적 종속성을 모델링할 수 있어 시계열 데이터와 관련된 작업에 적합하다는 점 등 여러 가지 장점을 제공합니다. 반복적인 특성 덕분에 가변 길이의 입력을 효과적으로 처리할 수 있습니다. 그러나 RNN은 학습 중에 기울기가 사라지거나 폭발하는 등의 문제가 발생하여 장거리 종속성을 정확하게 포착하는 데 한계가 있습니다. 또한, RNN의 순차적 특성으로 인해 병렬 처리가 제한되어 대규모 데이터 세트에는 계산적으로 비효율적입니다.

TOP 맨위로

4. 트랜스포머의 장점과 한계

트랜스포머는 자연어 처리(NLP, Natural Language Processing) 분야에 혁명을 일으켰으며 다양한 작업에서 인상적인 성능을 보여주었습니다. 병렬 처리 기능 덕분에 효율성이 매우 높아 학습 및 추론 시간을 단축할 수 있습니다. 또한 트랜스포머는 장거리 종속성을 포착하는 데 탁월하여 광범위한 컨텍스트가 포함된 작업에 이상적입니다. 하지만 트랜스포머는 효과적으로 일반화하기 위해 상당한 양의 학습 데이터가 필요하며 특정 애플리케이션의 경우 연산 집약적일 수 있습니다.

TOP 맨위로

5. 획기적인 연구 및 애플리케이션

RNN과 트랜스포머 모두에서 수많은 연구 발전이 이루어졌습니다. 연구원들은 이러한 모델의 성능과 효율성을 향상시킬 수 있는 방법을 지속적으로 모색하고 있습니다. 전이 학습에서 하이브리드 아키텍처에 이르기까지 RNN과 트랜스포머의 한계를 해결하기 위한 혁신적인 기술이 등장했습니다. 이러한 모델은 기계 번역, 감성 분석, 텍스트 생성 등에 적용되어 다양한 산업 및 연구 영역에서 발전을 주도하고 있습니다.

TOP 맨위로

6. 왜 트랜스포머(Transformer)라는 이름이 붙여졌나요?

트랜스포머 모델은 자연어 처리(NLP, Natural Language Processing) 분야에 혁명을 일으킨 독특하고 혁신적인 아키텍처(Transformative Architecture)에서 그 이름이 유래되었습니다. 기존의 순차 모델과 달리 트랜스포머는 모델이 입력 시퀀스의 여러 위치에 동시에 주의를 기울일 수 있는 자기 주의 메커니즘(Self-attention Mechanism)을 도입했습니다. 시퀀스 전반에서 종속성을 포착하는 이 혁신적인 접근 방식(Transformative Approach)은 "트랜스포머(Transformer)"라는 이름으로 이어졌습니다.

트랜스포머 모델은 위치 인코더를 사용해서 네트워크에 들어오고 나가는 데이터 요소에 태그를 지정합니다. 이러한 마커를 따라 Attention 단위는 한 요소가 다른 요소와 어떻게 연결되는지에 대한 대수적 맵(Algebraic Map)을 생성합니다. 트랜스포머 모델에서 Self-attention Mechanism의 중요도가 매우 높다보니 Google Brain은 이 모델의 이름을 "Attention Net"(Attention과 신경망 Neural Nets의 조합어)으로 명명할 뻔하기도 했었지만, Jakob Uszkoreit(트랜스포머 공동개발, senior software engineer, Google Research)가 "Transformer"를 제안했다고 합니다. 야콥은 트랜스포머 이름을 제안하면서, 말장난(playing semantics)삼아 "we were transforming representations"라고 했다고 합니다.

요약하자면, 장거리 종속성을 효율적으로 처리하고 계산을 병렬화(Multi-headed Attention)할 수 있는 트랜스포머 모델의 능력은 NLP 분야에서 획기적인 발전을 이루었으며, 연구에 미치는 혁신적인 변환 "Transforming Representations"의 중요성를 나타내는 의미로 '트랜스포머'라는 이름을 얻었습니다.

결론

요약하자면, 신경망 모델링에서 RNN과 트랜스포머의 주요 차이점을 이해하는 것은 신경망 모델링의 성능을 활용하기 위해 매우 중요합니다. RNN은 순차적인 작업에는 탁월하지만 장거리 종속성 때문에 어려움을 겪는 반면, 트랜스포머는 광범위한 컨텍스트를 효율적으로 처리합니다. 각 모델의 장점과 한계, 획기적인 연구 결과를 비교하여 특정 요구사항에 적합한 모델을 선택할 때 정보에 입각한 결정을 내릴 수 있습니다.

ChatGPT: AI의 미래를 위한 혁명적인 언어 모델

ChatGPT: AI의 미래를 위한 혁명적인 언어 모델

ChatGPT: AI 미래를 향한 언어 모델의 혁신(비기술적 설명) "OpenAI 언어 모델인 ChatGPT는 다양한 산업 분야에 맞는 다양한 스타일로 사람과 유사한 텍스트를 생성하지만 편견과 윤리적 영향을 미칠 수

starpopo.tistory.com

ChatGPT가 뭔가요? 경쟁사 AI 챗봇(Chatbot) 비교 분석! What Is ChatGPT? What does the ChatGPT do?

ChatGPT가 뭔가요? 경쟁사 AI 챗봇(Chatbot) 비교 분석! What Is ChatGPT? What does the ChatGPT do?

ChatGPT 과학기술의 이론적 이해: 경쟁사 AI 챗봇 비교분석! 어떤 AI 챗봇이 최강자인가? "ChatGPT는 OpenAI에서 개발한 대규모 언어 모델이자 AI 챗봇(Chatbot)입니다." 목차 1. ChatGPT란? 2. GPT-3.5란? 3. GPT-4란

starpopo.tistory.com

ChatGPT AI는 왜 거짓말을 하는가? AI 인공 환각 이해하기 Why does AI lie? Why do AI chatbots lie? Is AI capable o

Why does AI lie? 이 글에서는 인공지능이 생성한 결과에서 예기치 않은 결과, 즉 인공 환각(Artificial Hallucination)을 초래하는 요인을 조사합니다. AI의 편견, 제약, 현실 세계에 대한 이해 실패로 인해

starpopo.tistory.com

딥러닝과 머신러닝의 차이 비교

AI Deep Learning과 Machine Learning 차이점 비교 딥러닝과 머신러닝의 주요 차이점을 알아보세요. 머신러닝 알고리즘은 데이터(training data)에서 패턴을 추출하는 반면, 딥러닝은 신경망을 활용하여 복잡

starpopo.tistory.com

Unveiling the Power of Attention in Machine Learning: A Deep Dive into 'Attention is All You Need', AI 트랜스포머 논문

Summary - 'Attention is All You Need', AI 트랜스포머 논문 설명 Vaswani 외(2017)의 "주의력만 있으면 충분하다" -- "Attention is all you need" by Vaswani et al. (2017) -- 논문은 주의력 메커니즘에만 의존하는 기계 번역

starpopo.tistory.com

AI가 뭐죠? 누가 AI 이름을 지었나요? Who first introduced AI? Why is AI named AI? Who coined the term AI?

AI가 뭐죠? 누가 AI 이름을 지었나요? Who first introduced AI? Why is AI named AI? Who coined the term AI?

누가 언제 AI 이름을 지었나요? 일반적으로 AI로 약칭되는 인공 지능(Artificial Intelligence)은 기계가 인간과 유사한 지능을 모방하여 추론, 학습, 의사 결정, 지각, 언어 이해 등 일반적으로 인간의

starpopo.tistory.com

딥러닝 혁명가 제프리 힌튼, 딥러닝 아버지, The Father of Deep Learning

AI Deep Learning 딥러닝 혁명가 제프리 힌튼, 딥러닝 아버지, The Father of Deep Learning

Geoffrey Hinton, Deep Learning의 아버지, AI의 대부(Godfather)라 불리우다 인공 지능과 머신 러닝의 영역에서 진정한 선구자로 눈에 띄는 이름이 있습니다. 제프리 에베레스트 힌튼(Geoffrey Everest Hinton, 1947

starpopo.tistory.com

그리스 신화에 나오는 인공지능 AI: 인류 최초의 AI는 판도라? When did AI first begin? What was the first AI?

인류 최초의 AI는 판도라다? 신화와 전통은 지능형 기계에 대한 아이디어가 수천 년 동안 인류 문화에 존재해 왔으며 사람들이 인간의 행동과 지능을 모방할 수 있는 기계를 만드는 아이디어에

starpopo.tistory.com

인공지능 기초 입문 서적

https://starpopomk.blogspot.com/

Ask And Answer AI for Beginners

Discover the fascinating world of Artificial Intelligence. Learn about the types, history, current state, and ethical implications of AI.

starpopomk.blogspot.com

Playground AI 필터 사용법 설명

Playground AI 필터 사용법

AI 이미지 생성 방법의 기술적 이해: Playground AI 필터 사용법

Playground AI 필터 사용법 AI 그림 사이트 Playground AI에는 사용자가 원하는 효과를 표현하기 위해 손쉽게 사용가능한 필터가 약 50개 있습니다. 필터를 적용하기 위해서는 단순히 필터를 클릭해서 선

starpopo.tistory.com

TOP 맨위로

댓글